提高生产力,

,但风险也随之增加

人工智能编程工具、大型语言模型和机器学习编程工具的广泛应用带来了新的挑战:对人工智能生成的代码缺乏可视性和治理能力。

78%

- StackOverflow

30%

- arXiv

50%

- BaxBench

信任代理的好处:人工智能

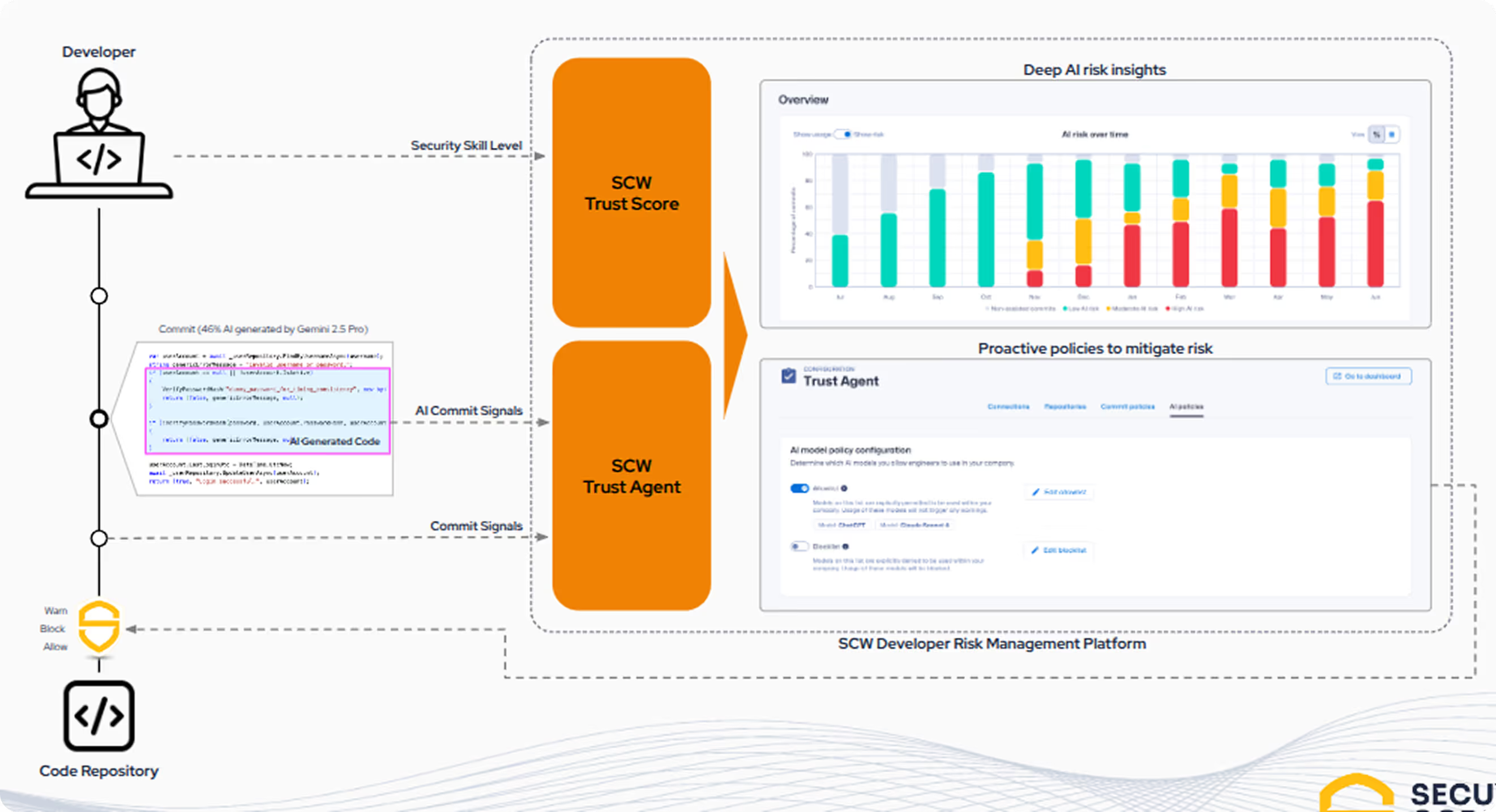

SCW Trust Agent 的全新人工智能功能提供了深入的可观察性和控制能力,可帮助您在软件开发生命周期(SDLC)中放心地管理人工智能的采用,而不会牺牲安全性。

人工智能在 SDLC 中的挑战

如果没有管理人工智能使用的方法,CISO、AppSec 和工程领导者就会面临新的风险和他们无法回答的问题。其中一些问题包括

- 无法了解哪些开发人员正在使用哪些模型。

- 使用人工智能编码工具的开发人员的安全熟练程度存在不确定性。

- 无法深入了解人工智能生成的代码在贡献代码中所占的比例。

- 无法执行管理人工智能编码工具风险的政策和治理。

我们的解决方案 -

Trust Agent:人工智能

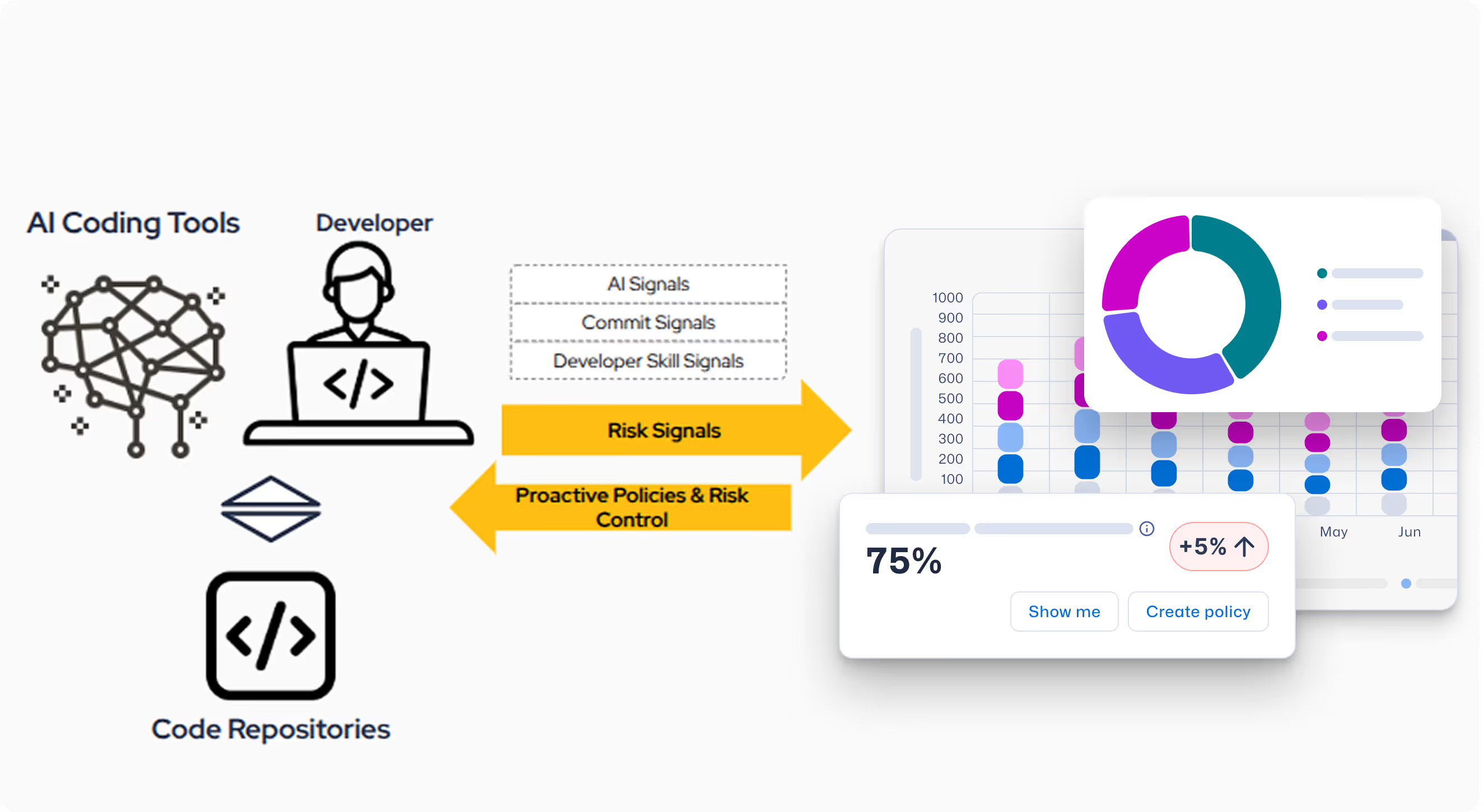

SCW 可帮助企业在不牺牲安全性的前提下加快人工智能驱动的开发速度。信任代理:人工智能是首个提供可视性和治理的解决方案,它通过将三个关键信号进行独特组合,在提交级别了解人工智能辅助开发人员的风险。

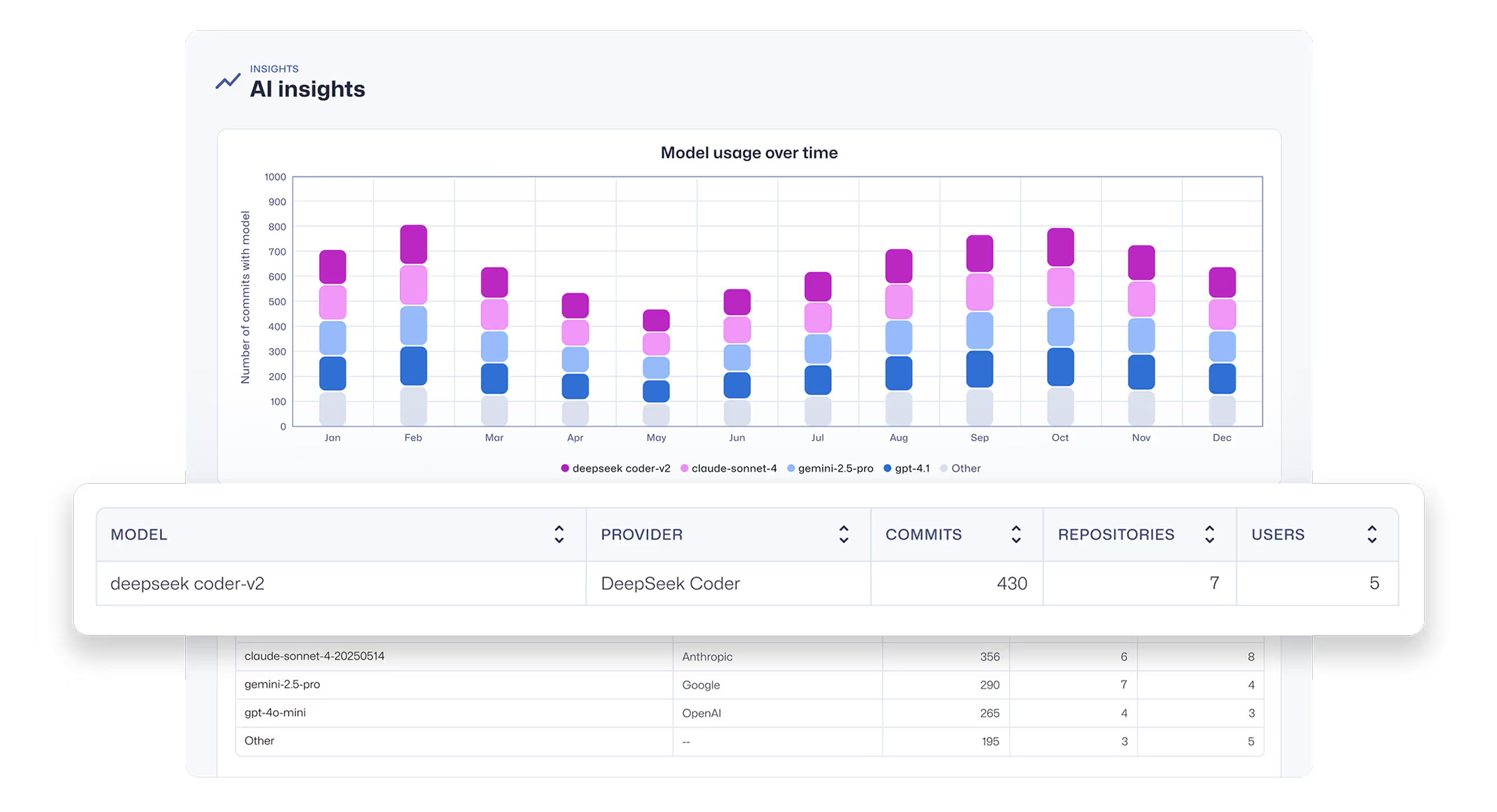

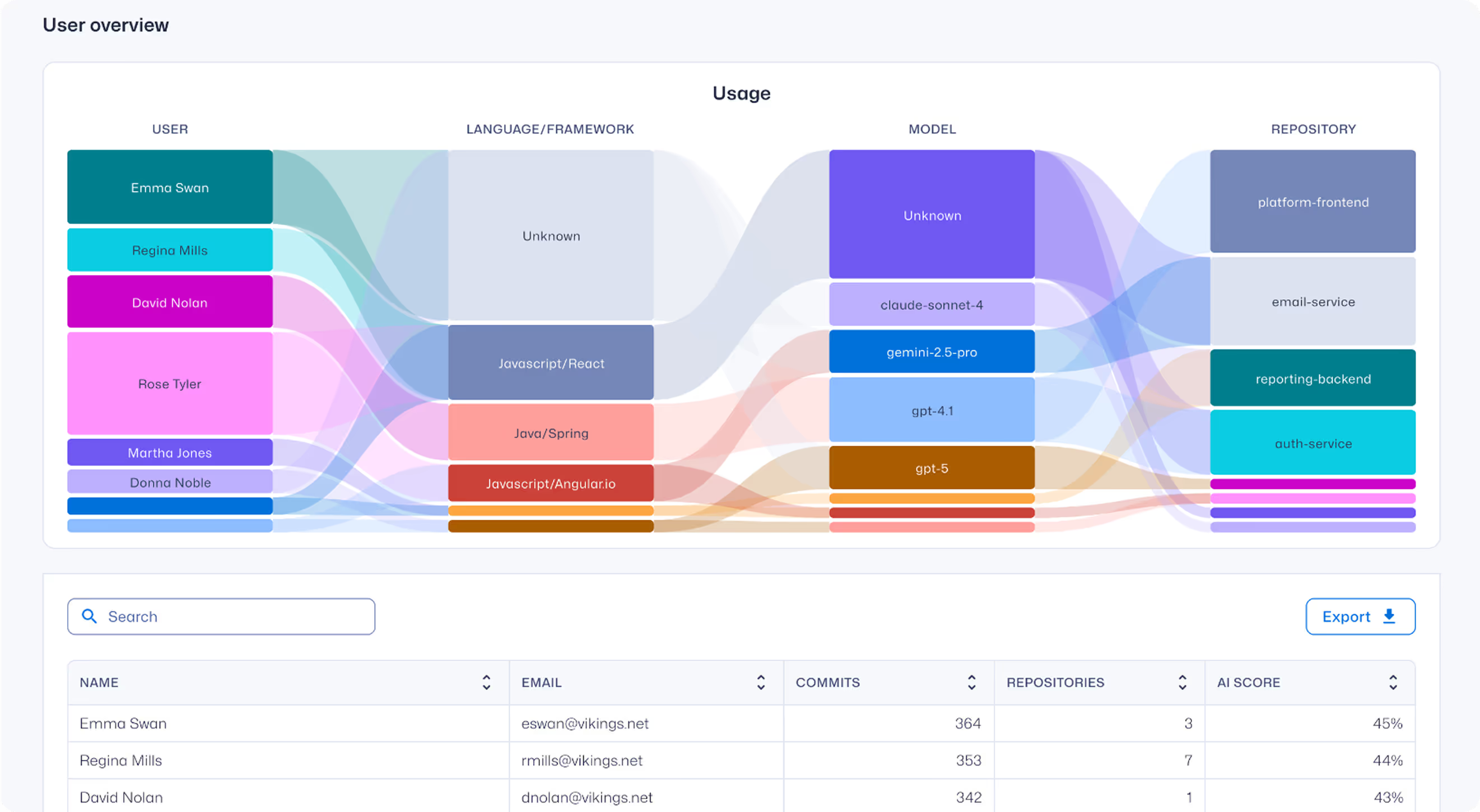

- AI编码工具使用情况:深入了解哪些用户正在使用哪些AI编码工具、大型语言模型(LLMs)和机器学习编程工具(MCPs),以及这些工具在哪些代码仓库中被使用。

- 实时捕捉信号信任代理:人工智能在开发人员的电脑和集成开发环境中拦截人工智能生成的代码。

- 开发人员的安全编码技能:我们可以清楚地了解开发人员的安全编码能力,这是负责任地使用人工智能所需的基本技能。

不再有 "影子人工智能"

全面了解人工智能编码助手和代理以及支持它们的 LLM。发现未经批准的工具和模型。

提交的深度可观察性

深入洞察人工智能辅助的软件开发过程,包括哪些开发人员正在使用哪些大型语言模型和机器学习组件,以及在哪些代码库中应用。

综合治理与控制

将人工智能生成的代码与实际提交连接起来,以了解引入的真正安全风险。自动执行策略,确保人工智能开发人员在其贡献被接受之前符合安全编码标准。

关于信任代理的问题:人工智能洞察

为什么要关注人工智能/LLM 生成的代码在 SDLC 中的风险?

随着开发人员越来越多地使用人工智能编码工具,SDLC 正在引入一层新的重要风险。调查显示,78% 的开发人员目前正在使用这些工具,但研究表明,多达 50% 的人工智能生成的代码包含安全漏洞。

缺乏管理以及开发人员知识与代码质量之间的脱节可能会迅速失控,因为每个不安全的人工智能生成组件都会增加组织的攻击面,使管理风险和维护合规性的工作变得更加复杂。

请阅读本白皮书中的更多内容:人工智能编码助手:新一代开发人员的安全导航指南

Trust Agent:人工智能能检测到什么?

信任代理:人工智能从人工智能助手和代理编码工具(如 GitHub Copilot、Cline、Roo Code 等)以及支持它们的 LLM 收集信号。

目前,我们检测 OpenAI、Amazon Bedrock、Google Vertex AI 和 Github Copilot 提供的所有模型。

Trust Agent:如何安装?

我们将为您提供一个 .vsix 文件,用于在 Visual Studio Code 中手动安装,而通过 Intune、Jamf 和 Kanji 的移动设备管理 (MDM) 脚本进行的自动部署也即将推出。

如何注册 Trust Agent:人工智能?

Trust Agent:人工智能目前处于测试阶段。若您感兴趣,请加入我们的早期体验候补名单。

%201.avif)

.avif)

.avif)